作者:余凯

前言

近几年,企业基础设施云原生化的趋势越来越强烈,从最开始的IaaS化到现在的微服务化,客户的颗粒度精细化和可观测性的需求更加强烈。容器网络为了满足客户更高性能和更高的密度,也一直在高速的发展和演进中,这必然对客户对云原生网络的可观测性带来了极高的门槛和挑战。为了提高云原生网络的可观测性,同时便于客户和前后线同学增加对业务链路的可读性,ACK产研和AES联合共建,梳理云原生网络数据面可观测性系列,帮助客户和前后线同学了解云原生网络架构体系,简化对云原生网络的可观测性的门槛,优化客户运维和售后同学处理疑难问题的体验 ,提高云原生网络的链路的稳定性。

鸟瞰容器网络,整个容器网络可以分为三个部分:Pod网段,Service网段和Node网段。这三个网络要实现互联互通和访问控制,那么实现的技术原理是什么?整个链路又是什么,限制又是什么呢?Flannel,Terway有啥区别?不同模式下网络性能如何?这些,需要客户在下搭建容器之前,就要依据自己的业务场景进行选择,而搭建完毕后,相关的架构又是无法转变,所以客户需要对每种架构特点要有充分了解。比如下图是个简图,Pod网络既要实现同一个ECS的Pod间的网络互通和控制,又要实现不同ECS Pod间的访问,Pod访问SVC 的后端可能在同一个ECS也可能是其他ECS,这些在不同模式下,数据链转发模式是不同的,从业务侧表现结果也是不一样的。

本文是[全景剖析容器网络数据链路]第七部分,主要介绍Kubernetes Terway DataPath V2模式下,数据面链路的转发链路,一是通过了解不同场景下的数据面转发链路,从而探知客户在不同的场景下访问链路的数据面表现,帮助客户进一步优化业务架构;另一方面,通过深入了解转发链路,从而在遇到容器网络抖动时候,客户运维以及阿里云同学可以知道在哪些链路点进行部署观测手动,从而进一步定界问题方向和原因。

系列一:全景剖析阿里云容器网络数据链路(一)—— Flannel

系列二:全景剖析阿里云容器网络数据链路(二)—— Terway ENI

系列三:全景剖析阿里云容器网络数据链路(三)—— Terway ENIIP

系列四:全景剖析阿里云容器网络数据链路(四)—— Terway IPVLAN+EBPF

系列五:全景剖析阿里云容器网络数据链路(五)—— Terway ENI-Trunking

系列六:全景剖析阿里云容器网络数据链路(六)—— ASM Istio

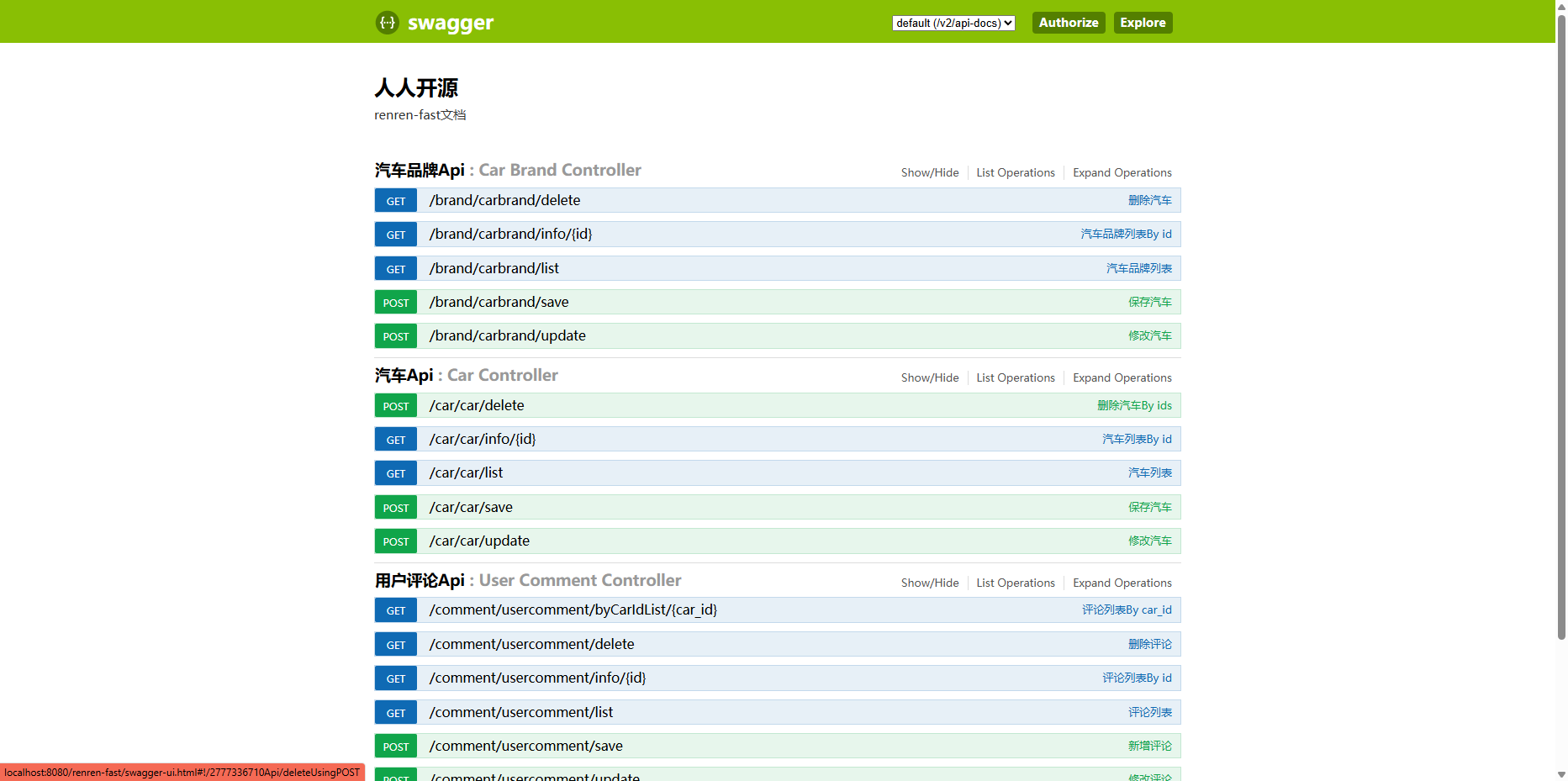

Terway DataPath V2 模式架构设计

弹性网卡(ENI)支持配置多个辅助IP的功能,单个弹性网卡(ENI)根据实例规格可以分配6~20个辅助IP,ENI多IP模式就是利用了这个辅助IP分配给容器,从而大幅提高了Pod部署的规模和密度。在网络联通的方式上,Terway目前支持veth pair策略路由和IPVLAN两种方案,但是社区在cilium v1.12版本后废弃了IPVLAN的支持 [ 1] ,为了统一数据面一致性,将ACK的数据面演进和社区保持一致,便于云原生的能力集成,减少差异化。从v1.8.0开始,Terway不再支持IPvlan隧道加速,而采用DataPath V2的方式进行数据面的统一。

Pod所使用的CIDR网段和节点的CIDR是同一个网段。

Pod内部有一张网卡eth0,其中eth0的IP就是Pod的IP,此网卡的MAC地址和控制台上的ENI的MAC地址不一致,同时ECS上有多张ethx的网卡,说明ENI附属网卡并不是直接挂载到了Pod的网络命名空间。

Pod内只有指向eth0的默认路由,说明Pod访问任何地址段都是从eth0为统一的出入口。

同时ECS上有多张ethx的网卡,说明ENI附属网卡并不是直接挂载到了Pod的网络命名空间。

通过OS Linux Routing可以得到,所有目的是Pod IP的流量都会被转发到Pod对应的calixx虚拟往卡上。因此,ECS OS和Pod的网络命名空间已经建立好完整的出入链路配置了。

对于ENI多IP的实现,这个类似于ACK容器网络数据链路(Terway ENIIP) [ 2] 原理,Terway Pod是通过Daemonset的方式部署在每个节点上的。通过terway-cli mapping命令可以得到节点上的附属ENI数量、MAC地址以及每个ENI上的IP。

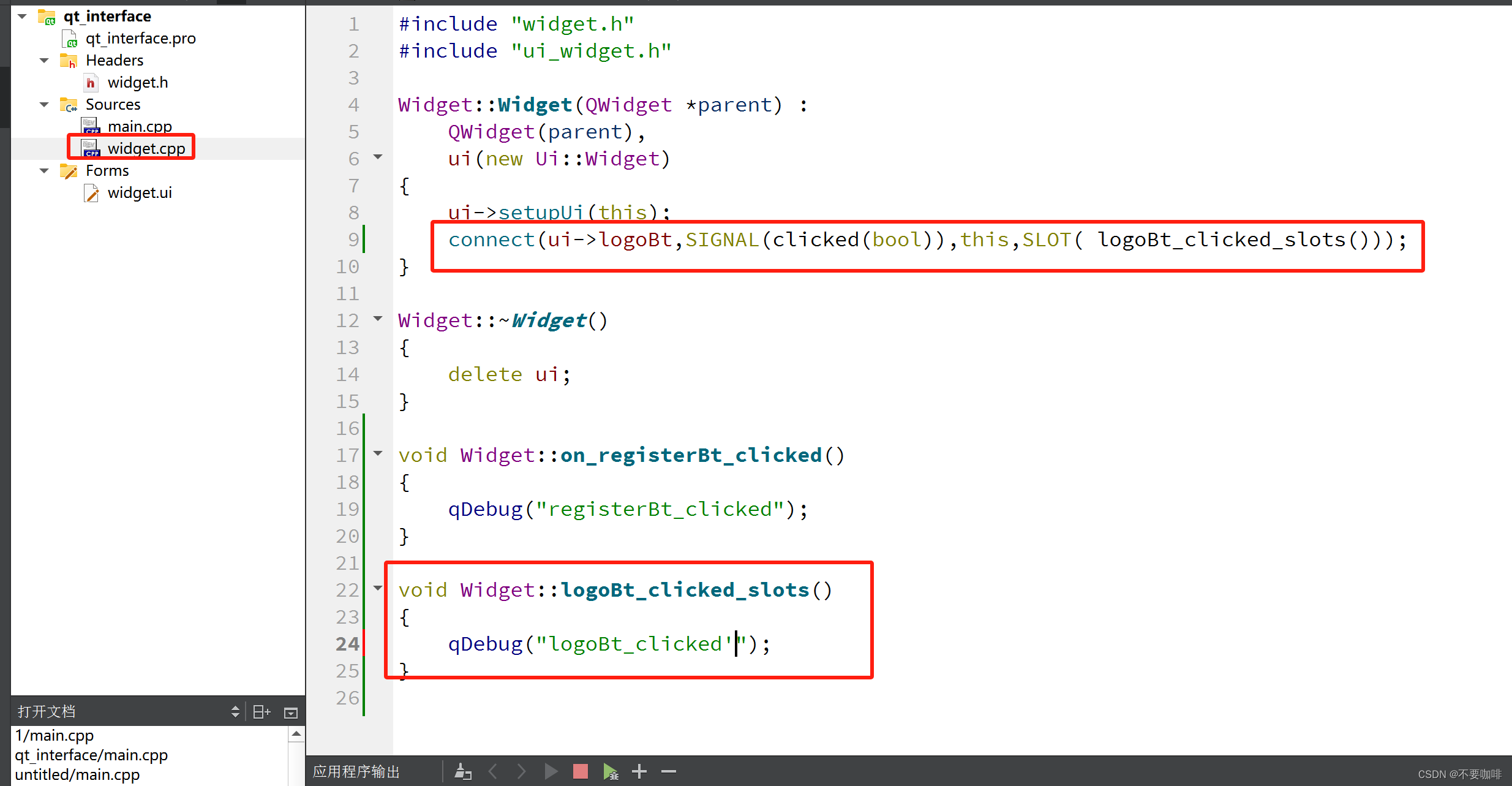

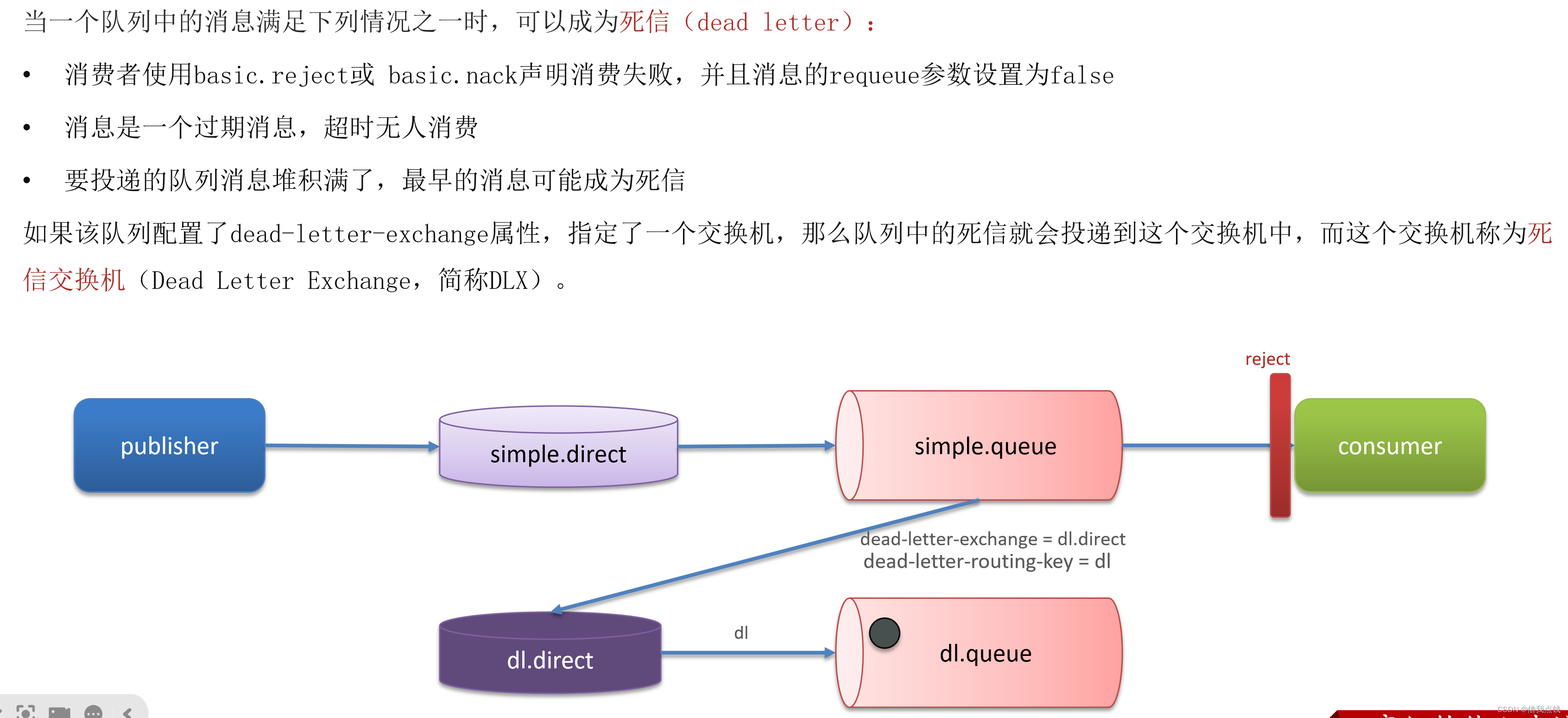

对于Pod访问SVC,容器是利用各种办法将请求转发到Pod所在的ECS层面,由ECS内的netfilter模块来实现SVC IP的解析。但是由于数据链路需要从Pod的网络命名空间切换到ECS的OS的网络命名空间,中间经过了对此内核协议栈,必然会产生性能损失,如果对高并发和高性能有机制追求,可能并不完全满足客户的需求。相比较IPVLAN模式将eBPF部署在Pod内部用于SVC地址转换,DataPath V2模式的eBPF监听在每个Pod的calixxx网卡上,用于实现Pod和Pod访问的加速,以及Pod访问SVC IP的地址转后的链路加速,模式比较可以参考使用Terway网络插件 [ 3] 。

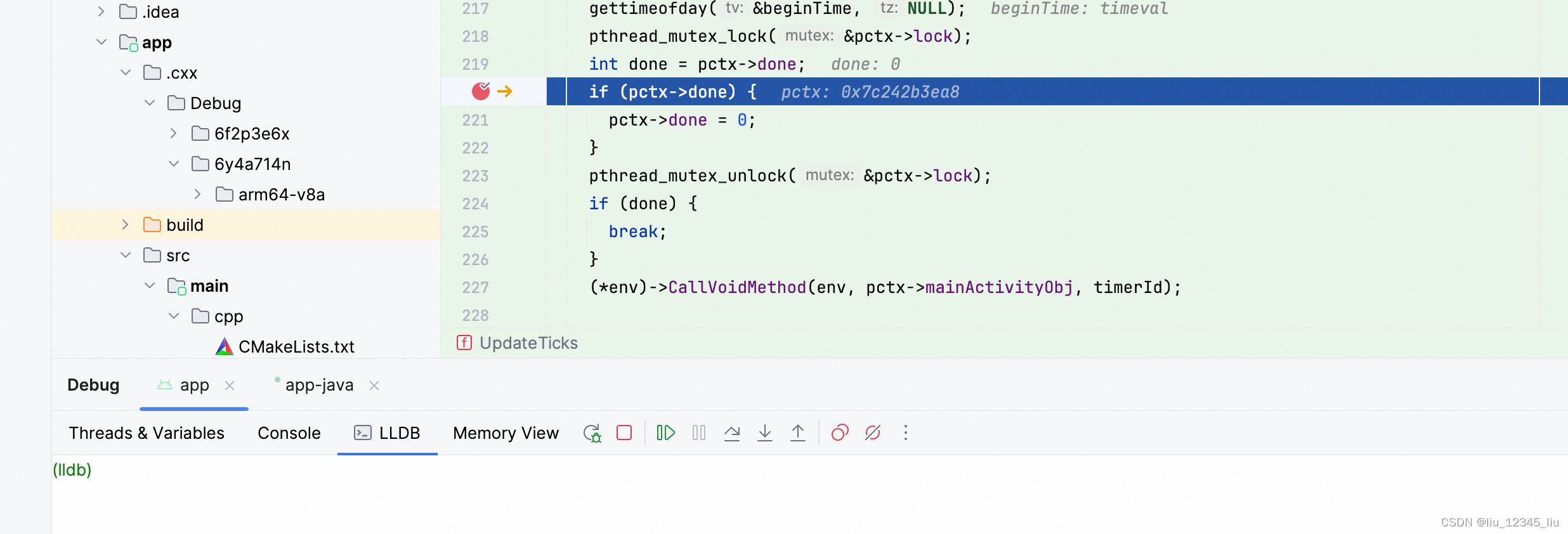

BPF Routing

5.10 内核以后,Cilium 新增了 eBPF Host-Routing 功能,新增了bpf_redirect_peer和bpf_redirect_neigh两个redirect方式。

-

bpf_redirect_peer

数据包不经过宿主机的lxc接口,直接被送到veth pair Pod里面接口eth0上,实现数据包少进入一次cpu backlog queue队列,获得更好的转发性能。

-

bpf_redirect_neigh

用来填充pod egress流量的src和dst mac地址,流量无需经过kernel的route协议栈处理过程。

故Terway DataPath V2模式总体可以归纳为:

- 目前低版本内核(低于4.2)不支持eBPF加速,Aliyun2可获得部分加速能力,Aliyun3可获得完整的加速能力。

- 节点访问Pod需要经过Host的协议栈,Pod和Pod间访问以及Pod访问SVC不经过Host的协议栈。

- DataPath V2模式下,如果Pod访问SVC IP,SVC IP在Pod的veth pair calixxx网卡上被eBPF转为某个SVC后端Pod的IP,之后数据链路绕过Host协议栈。也就是说SVC IP只会在源端Pod的veth pair被捕获,目的端Pod和目的端的Pod所在ECS都无法被捕获到。

Terway DataPath V2 模式容器网络数据链路剖析

针对容器网络特点,可以将Terway datapathv2模式下的网络链路大体分为以Pod IP对外提供服务和以SVC对外提供服务两个大的SOP场景,进一步细分,可以归纳为11个不同的小的SOP场景。

对这15个场景的数据链路梳理合并,这些场景可以总结为下面8类典型的场景:

- 访问Pod IP,同节点访问Pod

- 访问Pod IP,同节点Pod间互访(Pod属于同ENI)

- 访问Pod IP,同节点Pod间互访(Pod属于不同ENI)

- 访问Pod IP,不同节点间Pod之间互访

- 集群内Pod访问的SVC Cluster IP/External IP,SVC后端Pod和客户端Pod属同ECS同ENI

- 集群内Pod访问的SVC Cluster IP/External IP,SVC后端Pod和客户端Pod属同ECS不同ENI

- 集群内Pod访问的SVC Cluster IP/External IP,SVC后端Pod和客户端Pod属于不同ECS

- 集群外访问SVC External IP

场景一:访问Pod IP,同节点访问Pod(含节点访问后端为同一节点的SVC ClusterIP)

环境

xxx.10.0.1.219节点上存在nginx2-7ff4679659-xkpmm,IP地址10.0.0.2。

内核路由

nginx2-7ff4679659-xkpmm,IP地址10.0.0.2,该容器在宿主机中的PID是5630,容器网络命名空间有指向容器eth0的默认路由。

该容器eth0在ECS OS 内对应veth pair是cali10e985649a0,在ECS OS内,有指向Pod IP,下一跳为calixxx的路由,通过前文可以知道calixxx网卡是和每个Pod内的veth1组成的pair。

通过下面的命令我们可以获取到nginx2-7ff4679659-xkpmm,IP地址10.0.0.2被terway分配到了eth2附属网卡。

kubectl --kubeconfig kubeconfig -n kube-system exec -it terway-eniip-v5v2p -c terway – terway-cli mapping

小结

ECS的eth0捕获了从nginx2-7ff4679659-xkpmm返回的数据,但是没有捕获发送数据。

ECS的eth1同样也捕获了从nginx2-7ff4679659-xkpmm返回的数据,但是没有捕获发送数据。

cali10e985649a0可以捕获发和收的数据包。

后续小结不再展示数据报文观测。

数据链路转发示意图(Aliyun2&Aliyun3):

- 整个链路是经过了ECS和Pod的网络协议栈。

- 整个请求链路是:ECS OS -> calixxx -> ECS Pod eth0

场景二:访问Pod IP,同节点Pod间互访(Pod属于同ENI)

环境

xxx.10.0.1.219节点上存在nginx2-7ff4679659-xkpmm,IP地址10.0.0.2和centos-5bf8644bcf-jqxpk,IP地址10.0.0.13。

内核路由

centos-5bf8644bcf-jqxpk,IP地址10.0.0.13,该容器在宿主机中的PID是126938,容器网络命名空间有指向容器eth0的默认路由。

该容器eth0在ECS OS 内对应veth pair是calia7003b8c36c,在ECS OS内,有指向Pod IP,下一跳为calixxx的路由,通过前文可以知道calixxx网卡是和每个Pod内的veth1组成的pair。

nginx2-7ff4679659-xkpmm,IP地址10.0.0.2,该容器在宿主机中的PID是5630,容器网络命名空间有指向容器eth0的默认路由。

该容器eth0在ECS OS 内对应veth pair是cali10e985649a0,在ECS OS内,有指向Pod IP,下一跳为calixxx的路由,通过前文可以知道calixxx网卡是和每个Pod内的veth1组成的pair。

通过下面的命令我们可以获取到nginx2-7ff4679659-xkpmm和centos-5bf8644bcf-jqxpk都被terway分配到了eth2同一张附属网卡。

kubectl --kubeconfig kubeconfig -n kube-system exec -it terway-eniip-v5v2p -c terway – terway-cli mapping

小结

Aliyun2:

- 不会经过分配给Pod的附属网卡。

- 整个链路是经过了Pod的网络协议栈,链路由Pod的网络命名空间转发到对端时候,会经过eBPF加速绕过OS协议栈。

- 整个请求链路是:ECS Pod1 -> Pod1 calixxx -> Pod2 calixxx -> ECS Pod2。

Aliyun3:

- 不会经过分配给Pod的附属网卡。

- 整个链路会在eBPF的ingress被直接加速到目的Pod内,不会经过目的Pod的calixxx网卡。

- 整个请求链路是:

- 去方向:ECS Pod1 -> Pod1 calixxx -> ECS Pod2。

- 回方向:ECS Pod2 -> Pod2 calixxx -> ECS Pod1。

场景三:访问Pod IP,同节点Pod间互访(Pod属于不同ENI)

环境

xxx.10.0.1.219节点上存在ngxin3-55f5c67988-p4qnb和centos-5bf8644bcf-jqxpk两个Pod,IP地址分别为10.0.0.251和10.0.0.13。

此节点的terway Pod,利用terway-cli mapping的命令得到这两个IP(10.0.0.251和10.0.0.13)都属于不同ENI网卡,在OS层面是被认为是eth1和eth2。

内核路由

centos-5bf8644bcf-jqxpk,IP地址10.0.0.13,该容器在宿主机中的PID是126938,容器网络命名空间有指向容器eth0的默认路由。

该容器eth0在ECS OS 内对应veth pair是calia7003b8c36c,在ECS OS内,有指向Pod IP,下一跳为calixxx的路由,通过前文可以知道calixxx网卡是和每个Pod内的veth1组成的pair。

ngxin3-55f5c67988-p4qnb,IP地址10.0.0.251,该容器在宿主机中的PID是5630,容器网络命名空间有指向容器eth0的默认路由。

该容器eth0在ECS OS 内对应veth pair是cali08203025d22,在ECS OS内,有指向Pod IP,下一跳为calixxx的路由,通过前文可以知道calixxx网卡是和每个Pod内的veth1组成的pair。

小结

Aliyun2:

- 不会经过分配给Pod的附属网卡。

- 整个链路是经过了Pod的网络协议栈,链路由Pod的网络命名空间转发到对端时候,会经过eBPF加速绕过OS协议栈

- 整个请求链路是:ECS Pod1 -> Pod1 calixxx -> Pod2 calixxx -> ECS Pod2。

Aliyun3:

- 不会经过分配给Pod的附属网卡。

- 整个链路会在eBPF的ingress被直接加速到目的Pod内,不会经过目的Pod的calixxx网卡。

- 整个请求链路是:

- 去方向:ECS Pod1 -> Pod1 calixxx -> ECS Pod2。

- 回方向:ECS Pod2 -> Pod2 calixxx -> ECS Pod1。

场景四:访问Pod IP,不同节点间Pod之间互访

环境

xxx.10.0.1.219节点上存在centos-5bf8644bcf-jqxpk,IP地址为10.0.0.13。

xxx.10.0.5.27节点上存在nginx1-7bcf4ffdb4-6rsqz,IP地址为10.0.4.121。

可以利用terway-cli show factory的命令得到centos-5bf8644bcf-jqxpk的IP 10.0.0.13属于xxx.10.0.1.219上的MAC地址为00:16:3e:0d:74:23的ENI网卡。

同理可得到nginx1-7bcf4ffdb4-6rsqz的IP 10.0.4.121属于xxx.10.0.5.27上的MAC地址为00:16:3e:0c:ef:6c的ENI网卡。

内核路由

centos-5bf8644bcf-jqxpk,IP地址10.0.0.13,该容器在宿主机中的PID是126938,容器网络命名空间有指向容器eth0的默认路由。

该容器eth0在ECS OS 内对应veth pair是calia7003b8c36c,在ECS OS内,有指向Pod IP,下一跳为calixxx的路由,通过前文可以知道calixxx网卡是和每个Pod内的veth1组成的pair。

nginx1-7bcf4ffdb4-6rsqz,IP地址10.0.4.121,该容器在宿主机中的PID是7745,容器网络命名空间有指向容器eth0的默认路由。

该容器eth0在ECS OS 内对应veth pair是cali06cd16bb25f,在ECS OS内,有指向Pod IP,下一跳为calixxx的路由,通过前文可以知道calixxx网卡是和每个Pod内的veth1组成的pair。

小结

Aliyun2:

- 会经过宿主机OS的网络命名空间,但协议栈链路会被eBPF加速。

- 整个链路是需要从客户端Pod所属的ENI网卡出ECS再从目的Pod所属的ENI网卡进入ECS。

- 整个请求链路是ECS1 Pod1 -> ECS1 Pod1 calixxx -> ECS1 ENI ethx -> VPC -> ECS2 ENI ethx -> ECS2 Pod2 calixxx -> ECS2 Pod2。

Aliyun3:

- 整个链路是需要从客户端Pod所属的ENI网卡出发,再经过ECS再从目的Pod所属的ENI网卡进入ECS。

- 整个请求链路是:

- 去方向:ECS1 Pod1 -> ECS1 Pod1 calixxx -> ECS1 ENI ethx -> VPC -> ECS2 ENI ethx -> ECS2 Pod2。

- 回方向:ECS2 Pod2 -> ECS2 Pod2 calixxx -> ECS2 ENI ethx -> VPC -> ECS1 ENI ethx -> ECS1 Pod1。

场景五:集群内Pod访问的SVC Cluster IP/External IP,SVC后端Pod和客户端Pod属同ECS同ENI

环境

xxx.10.0.1.219节点上存在nginx2-7ff4679659-xkpmm,IP地址10.0.0.2和centos-5bf8644bcf-jqxpk,IP地址10.0.0.13。

其中nginx2-7ff4679659-xkpmm Pod是SVC nginx2的endpoint。

内核路由

内核路由类似场景2,此处不再叙述。

关于eBPF,在datapathv2中,eBPF监听在OS层面的calixxx网卡上,而非Pod内部。利用cilium去调用eBPF的能力,可以通过图示命令可以得到centos-5bf8644bcf-jqxpk和nginx2-7ff4679659-xkpmm identity ID分别是693和2702。

找到Pod所在的ECS的Terway Pod为terway-eniip-v5v2p,在Terway Pod中运行cilium bpf lb list | grep -A5 192.168.152.119命令可以得到eBPF中对于Cluster IP 192.168.152.119:80记录的后端是10.0.0.2:80。

小结

从客户端Pod centos-5bf8644bcf-jqxpk访问SVC。

客户端的centos-6c48766848-znkl8的calia7003b8c36c网卡观测,可以捕获SVC的IP和客户端的Pod IP。

在这个Pod centos-6c48766848-znkl8所属的附属网卡ENI上观测,未能捕获任何相关流量报文,说明流量从客户端的所属的calixx网卡到ENI之间经过了eBPF转换。

在Pod nginx2-7ff4679659-xkpmmI的cali10e985649a0观测,只能捕获centos和nginx的Pod IP。

cilium提供了一个monitor的功能,使用cilium monitor --related-to < endpoint ID > ,可以得到:源端Pod IP访问SVC IP 192.168.152.119,之后被解析到SVC的后端Pod IP 10.0.0.2,说明SVC IP直接在tc层做了转发。

Aliyun2:

- 整个链路是经过了Pod的网络协议栈,链路由Pod的网络命名空间转发到对端时候,会经过eBPF加速绕过OS协议栈。

- 整个链路请求未经过Pod所分配的ENI。

- SVC IP在客户端Pod的calixxx网卡通过eBPF转换成了SVC后端Pod的IP,后续节点无法捕获SVC IP。

- 整个请求链路是:ECS Pod1 -> Pod1 calixxx -> Pod2 calixxx -> ECS Pod2。

Aliyun3:

-

整个链路是经过了Pod的网络协议栈,链路由Pod的网络命名空间转发到对端时候,会经过eBPF加速绕过OS协议栈。

-

整个链路请求未经过Pod所分配的ENI。

-

SVC IP在客户端Pod的calixxx网卡通过eBPF转换成了SVC后端Pod的IP,后续节点无法捕获SVC IP。

-

整个链路会在eBPF的ingress被直接加速到目的Pod内,不会经过目的Pod的calixxx网卡。

-

整个请求链路是:

- 去方向:ECS Pod1 -> Pod1 calixxx -> ECS Pod2。

- 回方向:ECS Pod2 -> Pod2 calixxx -> ECS Pod1。

场景六:集群内Pod访问的SVC Cluster IP/External IP,SVC后端Pod和客户端Pod属同ECS不同ENI

环境

xxx.10.0.1.219节点上存在ngxin3-55f5c67988-p4qnb,IP地址10.0.0.251和centos-5bf8644bcf-jqxpk,IP地址10.0.0.13。

其中ngxin3-55f5c67988-p4qnb Pod是SVC nginx3的endpoint。

内核路由

内核路由类似场景3,此处不再叙述。

关于eBPF,在datapathv2中,eBPF监听在OS层面的calixxx网卡上,而非Pod内部。利用cilium去调用eBPF的能力,可以通过图示命令可以得到centos-5bf8644bcf-jqxpk和ngxin3-55f5c67988-p4qnb identity ID分别是693和94。

找到Pod所在的ECS的Terway Pod为terway-eniip-v5v2p,在Terway Pod中运行cilium bpf lb list | grep -A5 192.168.239.183命令可以得到eBPF中对于Cluster IP 192.168.239.183:80记录的后端是10.0.0.2:80。

小结

从客户端Pod centos-5bf8644bcf-jqxpk访问SVC。

客户端的centos-6c48766848-znkl8的calia7003b8c36c网卡观测,可以捕获SVC的IP和客户端的Pod IP。

在Pod centos-6c48766848-znkl8所属的附属网卡ENI和ngxin3-55f5c67988-p4qnb所属的附属网卡ENI上观测,未能捕获到相关流量,说明流量从客户端的所属的calixx网卡上被eBPF转换成SVC相关的endpoint后直接被短路到目的calixxx网卡。

在Pod ngxin3-55f5c67988-p4qnb所属的cali08203025d22观测,只能捕获centos和nginx的Pod IP。

cilium提供了一个monitor的功能,使用cilium monitor --related-to < endpoint ID >,可以得到:源端Pod IP访问SVC IP 192.168.239.183,之后被解析到SVC的后端Pod IP 110.0.0.251,说明SVC IP直接在tc层做了转发。

后续小节如果涉及SVC IP的访问,如有类似,不再做详细的说明。

Aliyun2:

- 会经过宿主机OS的网络命名空间,但协议栈链路会被eBPF加速。

- 整个链路请求未经过Pod所分配的ENI。

- SVC IP在客户端Pod的calixxx网卡通过eBPF转换成了SVC后端Pod的IP,后续节点无法捕获SVC IP。

- 整个请求链路是ECS1 Pod1 -> ECS1 Pod1 calixxx -> ECS2 Pod2 calixxx -> ECS2 Pod2。

Aliyun3:

- 不会经过分配给Pod的附属网卡。

- 整个链路会在eBPF的ingress被直接加速到目的Pod内,不会经过目的Pod的calixxx网卡。

- SVC IP在客户端Pod的calixxx网卡通过eBPF转换成了SVC后端Pod的IP,后续节点无法捕获SVC IP。

- 整个请求链路是:

- 去方向:ECS Pod1 -> Pod1 calixxx -> ECS Pod2。

- 回方向:ECS Pod2 -> Pod2 calixxx -> ECS Pod1。

场景七:集群内Pod访问的SVC Cluster IP/External IP,SVC后端Pod和客户端Pod属于不同ECS

环境

xxx.10.0.1.219节点上存在centos-5bf8644bcf-jqxpk,IP地址为10.0.0.13。

xxx.10.0.5.27节点上存在nginx1-7bcf4ffdb4-6rsqz,IP地址为10.0.4.121。

其中nginx1-7bcf4ffdb4-6rsqz Pod是SVC nginx1的endpoint。

内核路由

Pod访问SVC的Cluster IP,而SVC的后端Pod和客户端Pod部署在不同ECS上,此架构和场景四:不同节点间Pod之间互访 [ 4] 小节相似,只不过此场景是Pod访问SVC的Cluster IP。对于Cluster IP的eBPF转发进行描述,详情请见场景五和场景六。

小结

Aliyun2:

- 会经过宿主机OS的网络命名空间,但协议栈链路会被eBPF加速。

- 整个链路是需要从客户端Pod所属的ENI网卡出ECS再从目的Pod所属的ENI网卡进入ECS。

- 整个请求链路是ECS1 Pod1 -> ECS1 Pod1 calixxx -> ECS1 ENI ethx -> VPC -> ECS2 ENI ethx -> ECS2 Pod2 calixxx -> ECS2 Pod2。

Aliyun3:

-

整个链路是需要从客户端Pod所属的ENI网卡出发,再经过ECS再从目的Pod所属的ENI网卡进入ECS。

-

整个请求链路是:

- 去方向:ECS1 Pod1 -> ECS1 Pod1 calixxx -> ECS1 ENI ethx -> VPC -> ECS2 ENI ethx -> ECS2 Pod2。

- 回方向:ECS2 Pod2 -> ECS2 Pod2 calixxx -> ECS2 ENI ethx -> VPC -> ECS1 ENI ethx -> ECS1 Pod1。

场景八:集群外访问SVC External IP

环境

xxx.10.0.5.27 节点上存在nginx1-7bcf4ffdb4-6rsqz,IP地址为10.0.4.121。

通过describe SVC可以得到nginx Pod被加入到了SVC nginx的后端。SVC的Cluster IP是192.168.190.78。

内核路由

在SLB控制台,可以得到lb-3nsj50u4gyz623nitxxx虚拟服务器组的后端服务器组是两个后端nginx Pod的ENI eni-j6cgs979ky3evxxx。

从集群外部角度看,SLB的后端虚拟服务器组是SVC的后端Pod所属的ENI网卡,内网的IP地址就是Pod的地址。

小结

Aliyun2:

- ExternalTrafficPolicy为Local或Cluster模式下,SLB只会将Pod分配的ENI挂载到SLB的虚拟服务器组。

- 数据链路会经过Pod的Veth的calixxx网卡

- 数据链路:Client -> SLB -> Pod ENI + Pod Port -> ECS1 Pod1 calixxx -> ECS1 Pod1 eth0。

Aliyun3:

- ExternalTrafficPolicy为Local或Cluster模式下,SLB只会将Pod分配的ENI挂载到SLB的虚拟服务器组。

- 数据链路会被ECS的附属网卡上eBPF加速绕过Pod的Veth的calixxx网卡,直接进到Pod的网络命名空间。

- 数据链路:Client -> SLB -> Pod ENI + Pod Port -> ECS1 Pod1 eth0。

相关链接:

[1] 废弃了IPVLAN的支持

https://docs.cilium.io/en/v1.12/operations/upgrade/#deprecated-options

[2] ACK容器网络数据链路(Terway ENIIP)

https://help.aliyun.com/zh/ack/ack-managed-and-ack-dedicated/user-guide/ack-network-fabric-terway-eniip

[3] 使用Terway网络插件

https://help.aliyun.com/zh/ack/ack-managed-and-ack-dedicated/user-guide/work-with-terway

[4] 不同节点间Pod之间互访https://help.aliyun.com/zh/ack/ack-managed-and-ack-dedicated/user-guide/ack-network-fabric-terway-eni-trunking#RS9Nc